تم إنشاء Apache Hadoop لتحسين الاستخدام وحل المشكلات الرئيسية للبيانات الضخمة، حيث كانت وسائل الإعلام على شبكة الإنترنت تولد كميات كبيرة من المعلومات على أساس يومي، وأصبح من الصعب للغاية إدارة البيانات الخاصة بحوالي مليار صفحة من المحتوى.

في خطوة ثورية، اخترعت Google منهجية جديدة لمعالجة البيانات المعروفة باسم MapReduce. لاحقًا، بعد مرور عام، نشرت Google ورقة بيضاء حول إطار عمل Map Reducing، حيث استلهم دوج كاتينج ومايك كافاريلا الورقة البيضاء، وبالتالي أنشأ Hadoop لتطبيق هذه المفاهيم على إطار عمل برمجي مفتوح المصدر يدعم مشروع محرك بحث Nutch. وبالنظر إلى دراسة الحالة الأصلية، فقد تم تصميم Hadoop بمرافق بنية تحتية للتخزين أبسط بكثير.

يعد Apache Hadoop الإطار الأكثر أهمية للعمل مع البيانات الضخمة. أكبر قوة Hadoop هي قابلية التوسع. يقوم بالترقية من العمل على عقدة واحدة إلى آلاف العقد دون أي مشكلة وبطريقة سلسة.

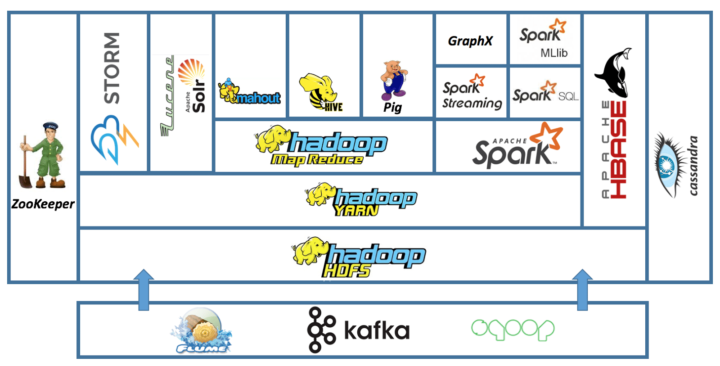

يتكون Hadoop من مكونات رئيسية اثنين:

- نظام الملفات الموزعة (HDFS): وهو نظام ملفات خاص يخزن مجموعات البيانات الكبيرة عبر أجهزة كمبيوتر متعددة.

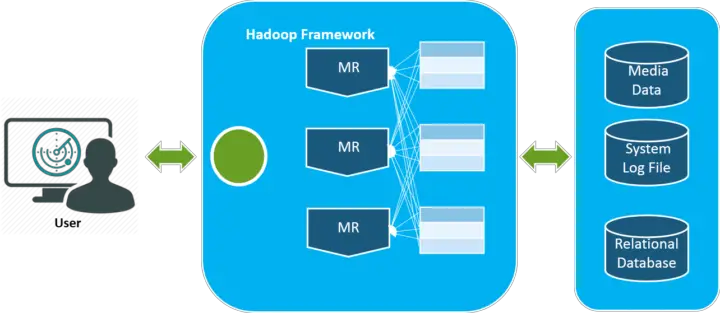

- نموذج MapReduce: وهو نموذج برمجي بسيط يستخدم لمعالجة البيانات الضخمة بشكل موزع.

يستخدم Hadoop على نطاق واسع من قبل الشركات وال organizations لتطبيقات متنوعة، بما في ذلك:

- معالجة السجلات: يمكن استخدام Hadoop لجمع وتحليل كميات كبيرة من بيانات السجلات، والتي يمكن أن تكون مفيدة لتصحيح أخطاء البرامج واكتشاف الاحتيال وفهم سلوك العملاء.

- فهرسة الويب: يمكن استخدام Hadoop لفهرسة الويب، وهو أمر أساسي لمحركات البحث مثل Google و Bing.

- الحوسبة العلمية: يمكن استخدام Hadoop لتشغيل عمليات محاكاة علمية واسعة النطاق، مثل نمذجة المناخ واكتشاف الأدوية.

- ذكاء الأعمال: يمكن استخدام Hadoop لتحليل كميات كبيرة من بيانات الأعمال، مثل معاملات العملاء والسجلات المالية.

Hadoop هو أداة قوية لمعالجة البيانات الضخمة، ولكن من المهم ملاحظة أنه ليس حلاً سحريًا. من المهم اختيار الأداة المناسبة للوظيفة، ولا يكون Hadoop دائمًا الخيار الأفضل. على سبيل المثال، Hadoop ليس مناسبًا للتطبيقات التي تتطلب معالجة في الوقت الفعلي أو زمن انتقال منخفض.

فيما يلي بعض الميزات الرئيسية لـ Apache Hadoop:

- قابلية التوسع: يمكن توسيع Hadoop ليشمل آلاف الأجهزة، مما يجعله مثاليًا لمعالجة مجموعات بيانات كبيرة جدًا.

- تحمل الأخطاء: Hadoop مصمم ليكون متسامحًا مع الأخطاء، مما يعني أنه يمكنه الاستمرار في العمل حتى لو فشلت بعض الأجهزة في المجموعة.

- التكلفة الفعالة: Hadoop هو برنامج مفتوح المصدر، مما يعني أنه مجاني للاستخدام والتوزيع.

- التنوع: يمكن استخدام Hadoop لتشغيل مجموعة متنوعة من التطبيقات، من معالجة السجلات إلى الحوسبة العلمية.

إذا كنت تعمل مع البيانات الضخمة، فإن Apache Hadoop هو أداة يجب عليك التفكير فيها. إنها منصة قوية ومرنة يمكن استخدامها لحل مجموعة متنوعة من المشكلات.

المصادر

- en.wikipedia.org/wiki/Apache_Hadoop

- arc.umich.edu/document/overview-3/

- https://intellipaat.com/blog/tutorial/hadoop-tutorial/introduction-hadoop/